Hay errores humanos. Hay fallos técnicos. Y luego está esta nueva frontera inquietante: cuando una decisión judicial se apoya en una jurisprudencia que nunca existió, generada por una Inteligencia Artificial que “alucinó” … y nadie lo comprobó.

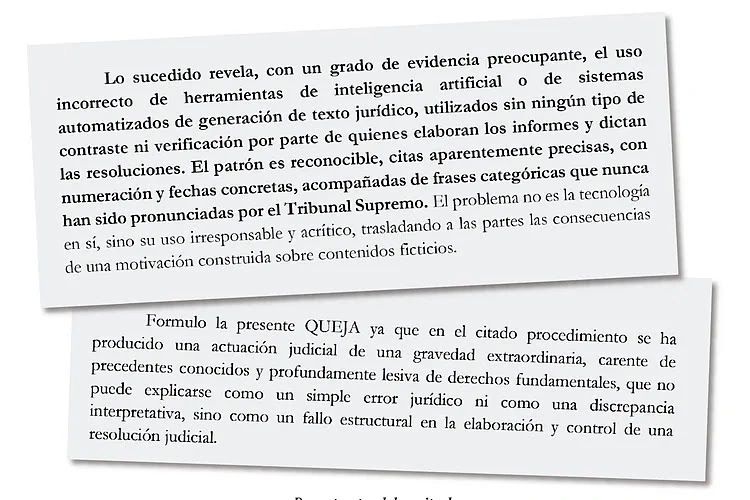

No es ciencia ficción. No es un capítulo de Black Mirror. Es España, enero de 2026. Por primera vez, un magistrado ha sido denunciado ante el Consejo General del Poder Judicial por haber fundamentado una resolución en sentencias del Tribunal Supremo que no existen. Citas completas, con número, fecha, doctrina literal entrecomillada… todo perfectamente verosímil. Todo completamente falso. Un producto típico de los grandes modelos de lenguaje cuando rellenan vacíos con convicción matemática.

La pregunta que hoy sacude a juristas, tecnólogos y ciudadanos no es si la IA se equivocó. La pregunta es más incómoda: ¿Cómo pudo nadie darse cuenta?

La alucinación que entró en el juzgado

La escena es casi simbólica. Un recurso. Un informe de Fiscalía. Una resolución judicial. Y, en la base de todo, una jurisprudencia “precisa”, “categórica”, “del Supremo” … que jamás fue dictada.

El patrón es reconocible para cualquier usuario de IA generativa: referencias aparentemente impecables, estructura jurídica perfecta, tono solemne, seguridad absoluta. Y, sin embargo, pura ficción.

La máquina no mintió: completó estadísticamente. El problema es que el sistema judicial no verificó.

Y ahí se abre una grieta que va mucho más allá de un caso concreto. Porque la Justicia no se fundamenta en probabilidades, sino en certezas. No en verosimilitud, sino en verdad contrastada. No en textos plausibles, sino en resoluciones reales.

Cuando una sentencia se apoya en algo inexistente, no estamos ante un simple error. Estamos ante un fallo estructural del principio de legalidad.

Vivimos en la era de la productividad algorítmica. La IA redacta más rápido que cualquier letrado, resume miles de páginas en segundos, propone estructuras argumentales impecables. En un sistema judicial saturado, colapsado y presionado por plazos imposibles, la tentación es enorme.

¿Quién no querría un asistente que busque jurisprudencia, sintetice doctrina, proponga fundamentos jurídicos?

El problema no es usarla. El problema es delegar en ella sin control.

Porque la IA no distingue entre una sentencia real y una plausible. No “sabe” qué es verdad. Solo calcula qué texto es más probable que encaje. Y cuando no encuentra, inventa con estilo.

En el mundo técnico lo llamamos “alucinación”. En el mundo jurídico, eso se llama indefensión.

Cuando la autoridad amplifica el error

Que un abogado cite una sentencia inexistente es grave. Que lo haga un fiscal es alarmante. Que un juez la incorpore sin verificación y la convierta en fundamento de una resolución es, como señala el escrito ante el CGPJ, devastador desde el punto de vista constitucional.

Porque en ese instante ocurre algo nuevo: una ficción algorítmica se transforma en verdad jurídica.

La IA no tiene poder. El juez sí. Y cuando el poder valida el error, el error se institucionaliza.

Este caso no habla de chips, ni de modelos de lenguaje, ni de redes neuronales. Habla de algo más profundo: de cómo construimos la verdad en la era digital.

Durante siglos, la prueba, la jurisprudencia, el precedente, se basaban en documentos verificables, rastreables, archivados. Hoy, un texto puede parecer perfecto, citar fuentes inexistentes y engañar incluso a profesionales entrenados.

La frontera entre lo real y lo generado se ha vuelto borrosa. Y en Derecho, la borrosidad es letal.

Porque el Estado de Derecho se sostiene sobre una premisa básica:

las decisiones deben fundarse en hechos y normas reales, no en simulaciones convincentes.

La Justicia frente al espejo de la IA

Este caso marca un antes y un después. No por el juez concreto. No por el abogado denunciante. Sino porque es la primera vez que el sistema judicial se mira en el espejo de la Inteligencia Artificial… y descubre que puede ser engañado.

• Descubre que puede citar fantasmas.

• Descubre que puede razonar sobre ficciones.

• Descubre que su liturgia formal puede ser impecable… y su base, inexistente.

Y eso obliga a una reflexión urgente:

• ¿Cómo se audita el uso de IA en la elaboración de resoluciones?

• ¿Quién verifica las fuentes generadas por sistemas automáticos?

• ¿Debe declararse cuándo se ha utilizado asistencia algorítmica?

• ¿Dónde queda la responsabilidad humana indelegable?

La paradoja: máquinas exactas, humanos acríticos

La tecnología no falló. Hizo exactamente lo que está diseñada para hacer: generar texto coherente.

Falló el control humano. Falló la verificación. Falló el eslabón más importante de la cadena: el criterio.

La IA no tiene deber de diligencia. El juez sí.

La IA no responde ante el CGPJ. El juez sí.

La IA no jura la Constitución. El juez sí.

Por eso el problema no es que la máquina “alucine”. El problema es que el sistema confíe.

Estamos entrando en una nueva alfabetización digital: la era de la prueba generada, del documento sintético, de la jurisprudencia fabricable.

La Justicia necesita, urgentemente, una alfabetización algorítmica. No para programar, sino para entender límites. Para saber qué puede hacer una IA… y, sobre todo, qué no puede garantizar jamás: la verdad.

Porque una sentencia no puede basarse en probabilidad estadística.

Un auto no puede descansar sobre texto verosímil. Un derecho fundamental no puede depender de una “respuesta plausible”.

Lo ocurrido en Ceuta no es un escándalo aislado. Es una señal temprana. Una grieta visible de un problema que crecerá.

Hoy es una jurisprudencia inexistente. Mañana puede ser un peritaje automático mal interpretado. Pasado, una valoración probatoria generada por un sistema opaco. Y entonces ya no hablaremos de errores. Hablaremos de modelo de justicia.

La pregunta que queda en el aire

En la era de la Inteligencia Artificial, ¿quién custodia la verdad?

Porque si la tecnología puede generar argumentos, precedentes y fundamentos que nunca existieron, y el sistema los incorpora sin contraste, entramos en una zona peligrosa: la de la justicia sintética.

Una justicia que parece sólida.

Que suena correcta.

Que cita, estructura, razona…

pero cuya base puede ser una ilusión estadística.

Y ahí, el riesgo ya no es técnico. Es civilizatorio.